一颗芯片的新战南宫28官网- 南宫28官方网站- APP下载争

2025-10-07南宫28官网,南宫28官方网站,南宫28APP下载以往每年9月,都是手机发烧友的狂欢月,因为这时期苹果、小米、华为等都会发新机。然而,今年的9月,一个更深层次的产业变革正在暗流涌动。当所有人都在对iphone 17的续航、联网、铝合金质感等“找茬”时,一场关于AI推理芯片的战争,已悄然打响。

过去几年,云厂商为了训练大模型投入巨资购买芯片,如今也到了利用推理实现变现的时候了。根据麦肯锡报告,全球AI推理市场规模预计2028年将达1500亿美元,年复合增长率超40%,远高于训练市场的20%。推理支撑着各类应用的实时推理需求,包括智能推荐、内容生成、虚拟助手等。可以说,推理阶段才是实现实际应用和商业化的关键。

这场推理之战,随着华为、英伟达和谷歌三大巨头相继发布了各自的推理芯片之后,已经将正式打响!

9月18日,在2025年华为全联接大会上,华为宣布了昇腾芯片的规划和进展。未来3年,也就是到2028年,华为在开发和规划了三个系列,分别是Ascend 950系列、Ascend 960、Ascend 970系列。华为表示,将以几乎一年一代算力翻倍的速度,同时围绕更易用,更多数据格式、更高带宽等方向持续演进,持续满足AI算力不断增长的需求

焦点落在即将推出的Ascend 950系列,特别是Ascend 950PR和950DT两颗芯片,它们均采用同一Ascend 950 Die(芯片裸片)。Ascend 950PR专攻推理Prefill阶段和推荐业务,采用华为自研的低成本HBM(高带宽内存)——HiBL 1.0。相较于高价位的HBM3e/4e,能够大大降低推理Prefill阶段和推荐业务的投资,这在规模化部署中至关重要。芯片预计2026年一季度面世,首发形态包括标准卡和超节点服务器。

低精度支持:新增支持业界标准FP8/MXFP8/MXFP4等低数值精度数据格式,算力分别达到1P和2P,提升训练效率和推理吞吐。并特别支持华为自研的HiF8,在保持FP8的高效的同时,精度非常接近FP16。

向量算力跃升:通过提高向量单元占比、创新同构设计(支持SIMD/SIMT双编程模型)和细化内存访问颗粒度(从512B降至128B),更好地处理碎片化数据。

互联带宽翻倍:互联带宽相比Ascend 910C提升了2.5倍,达到2TB/s。

定制HBM策略:结合结合推理不同阶段对于算力、内存、访存带宽及推荐、训练的需求不同,华为自研了两种HBM:HiBL 1.0针对Prefill和推荐,HiZQ 2.0则面向Decode(解码)和训练。这种“Die+HBM合封”模式,类似英伟达的CoWoS封装,但更注重成本控制,体现了华为的成本-性能平衡之道。

低精度支持:新增支持业界标准FP8/MXFP8/MXFP4等低数值精度数据格式,算力分别达到1P和2P,提升训练效率和推理吞吐。并特别支持华为自研的HiF8,在保持FP8的高效的同时,精度非常接近FP16。

向量算力跃升:通过提高向量单元占比、创新同构设计(支持SIMD/SIMT双编程模型)和细化内存访问颗粒度(从512B降至128B),更好地处理碎片化数据。

互联带宽翻倍:互联带宽相比Ascend 910C提升了2.5倍,达到2TB/s。

定制HBM策略:结合结合推理不同阶段对于算力、内存、访存带宽及推荐、训练的需求不同,华为自研了两种HBM:HiBL 1.0针对Prefill和推荐,HiZQ 2.0则面向Decode(解码)和训练。这种“Die+HBM合封”模式,类似英伟达的CoWoS封装,但更注重成本控制,体现了华为的成本-性能平衡之道。

从行业视角看,Ascend 950PR的低成本HBM策略直击全球痛点:一方面是从一定程度上解决HBM供给紧缺,另一方面降低成本,在AI推理中,内存成本占总支出的40%以上。华为此举不仅挑战国外厂商在HBM垄断,还为中国本土生态注入活力,预计将加速AI在边缘计算和云服务的落地。

9月9日,英伟达重磅推出Rubin CPX,一款专为大规模上下文处理设计的GPU。这标志着英伟达从“训练霸主”向“推理专家”的蔓延。这款芯片预计于 2026 年底上市。

黄仁勋强调,Rubin CPX开创了“CPX”新处理器类别,类似于RTX对图形领域的颠覆。它针对百万Token级上下文,处理速度和效率远超传统GPU。例如,在视频生成中,AI需处理上百万Token(相当于一小时视频),传统系统已达极限。Rubin CPX集成视频编解码器和长上下文推理技术于单芯片,支持NVFP4精度,峰值算力30 Petaflops,内存128GB GDDR7。

经济配置:单晶片设计降低成本,支持InfiniBand或Spectrum-X网络,扩展性强。英伟达宣称,每1亿美元投资可获50亿美元Token收益,ROI(投资回报率)高达5倍。

应用转型:从简单代码生成到优化大型软件项目,Rubin CPX让AI助理更智能。

经济配置:单晶片设计降低成本,支持InfiniBand或Spectrum-X网络,扩展性强。英伟达宣称,每1亿美元投资可获50亿美元Token收益,ROI(投资回报率)高达5倍。

应用转型:从简单代码生成到优化大型软件项目,Rubin CPX让AI助理更智能。

英伟达的洞察在于:长上下文是AI Agent的核心瓶颈。Gartner报告显示,到2027年,80%的AI应用将涉及多模态长序列处理。Rubin CPX的上市(2026年底),将巩固英伟达的生态霸权。

在9月份圣克拉拉举行的人工智能基础设施峰会上,谷歌人工智能和计算基础设施总经理 Mark LohmeyerMark Lohmeyer分享的数据显示,谷歌内部的推理请求量在过去一年里呈几何级增长,如下图所示,谷歌应用中的推理令牌(token)使用量在 2024年4月到2025年4月间,增长了惊人的50倍。这种增长趋势在2025年下半年变得更加陡峭,仅2025年6月到8月,月推理速率就从980万亿个飙升至接近1460万亿个。这凸显了高性能推理芯片的迫切需求。

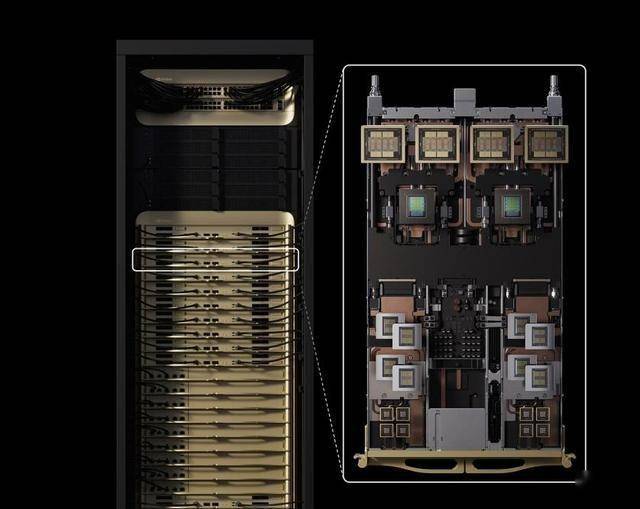

一排七个Ironwood TPU 机架,每排一个CDU和一个网络机架。这是谷歌首次展示一排 Ironwood 机器。(图源:Google)

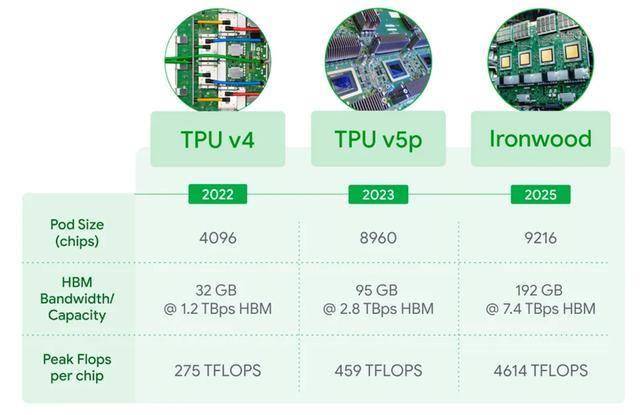

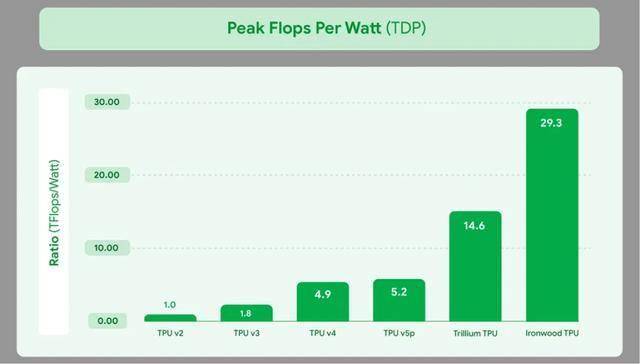

功率效率大幅提升:Ironwood的功率接近10兆瓦,功率效率是Trillium的1.5倍。每瓦性能是第六代 TPU Trillium 的两倍,比2018年推出的首款云TPU 高出近30倍。

功率效率大幅提升:Ironwood的功率接近10兆瓦,功率效率是Trillium的1.5倍。每瓦性能是第六代 TPU Trillium 的两倍,比2018年推出的首款云TPU 高出近30倍。

内存带宽飞跃:Ironwood单芯片容量高达 192 GB,是 Trillium 的 6 倍;单芯片带宽达到 7.37 TB/s,是Trillium的 4.5 倍。通过突破性的芯片间互联 (ICI) 网络连接,双向带宽提升至 1.2 TBps,从而实现更快的芯片间通信,

OCS互联联科技:一个通过谷歌独特的光路交换机(OCS)互连的 Ironwood 集群,可以利用 9,216 个 Ironwood TPU,在训练和推理工作负载上提供总计 1.77 PB 的 HBM 内存容量,碾压英伟达Blackwell机架的20.7TB。这种 OCS 互连具有动态重构能力,可以在不重启整个训练和推理任务的情况下,修复TPU 故障。

软件栈革命:除了支持 JAX AI 框架外,Ironwood TPU现在也支持原生的 PyTorch;此外,谷歌自己的Pathways堆栈,能够简化万级TPU管理。

内存带宽飞跃:Ironwood单芯片容量高达 192 GB,是 Trillium 的 6 倍;单芯片带宽达到 7.37 TB/s,是Trillium的 4.5 倍。通过突破性的芯片间互联 (ICI) 网络连接,双向带宽提升至 1.2 TBps,从而实现更快的芯片间通信,

OCS互联联科技:一个通过谷歌独特的光路交换机(OCS)互连的 Ironwood 集群,可以利用 9,216 个 Ironwood TPU,在训练和推理工作负载上提供总计 1.77 PB 的 HBM 内存容量,碾压英伟达Blackwell机架的20.7TB。这种 OCS 互连具有动态重构能力,可以在不重启整个训练和推理任务的情况下,修复TPU 故障。

软件栈革命:除了支持 JAX AI 框架外,Ironwood TPU现在也支持原生的 PyTorch;此外,谷歌自己的Pathways堆栈,能够简化万级TPU管理。

展示的是一块带有四个 Ironwood TPU 的系统板。每个芯片(带有金色盖子的方形物体)旁边都有四个长条状的内存模块,这些是高带宽内存(HBM)。这块板卡是谷歌为了将四个TPU芯片封装在一起,从而提供极高的算力和内存带宽而设计的。

谷歌不仅在硬件上发力,还展示了一整套针对AI推理优化的软件堆栈,旨在显著提升效率和降低成本。

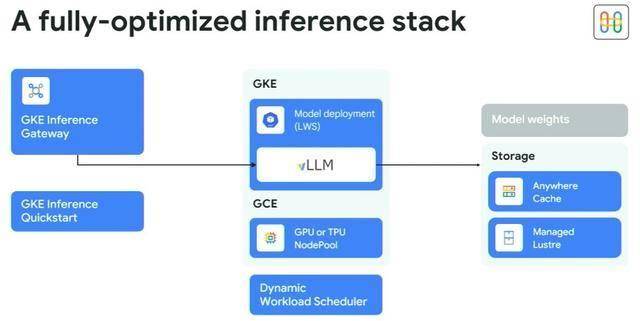

GKE是Google Cloud上托管的Kubernetes容器服务,类似于内部使用的Borg和Omega控制器。GKE Inference Gateway 是一个新的服务,利用AI注入的智能负载均衡,将推理请求分发到计算引擎池,其目标是减少任务排队,提高利用率;确定不同部分推理硬件和软件堆栈的配置是一个艰巨的任务,因此谷歌创建了 GKE Inference Quickstart 工具,这也是一个新工具,现已普遍可用。

Anywhere Cache:这是一个新的闪存缓存服务,可大幅减少延迟和网络成本。它能将谷歌云区域内的读取延迟提高 70%,跨区域延迟提高 96%。

Managed Lustre服务是一个高性能文件系统,用于向 GPU和TPU集群提供数据。

Lohmeyer还展示了另一项名为推测解码的技术,该技术已被用于提高其Gemini模型的性能,并将其能耗降低了约33倍。

GKE是Google Cloud上托管的Kubernetes容器服务,类似于内部使用的Borg和Omega控制器。GKE Inference Gateway 是一个新的服务,利用AI注入的智能负载均衡,将推理请求分发到计算引擎池,其目标是减少任务排队,提高利用率;确定不同部分推理硬件和软件堆栈的配置是一个艰巨的任务,因此谷歌创建了 GKE Inference Quickstart 工具,这也是一个新工具,现已普遍可用。

Anywhere Cache:这是一个新的闪存缓存服务,可大幅减少延迟和网络成本。它能将谷歌云区域内的读取延迟提高 70%,跨区域延迟提高 96%。

Managed Lustre服务是一个高性能文件系统,用于向 GPU和TPU集群提供数据。

Lohmeyer还展示了另一项名为推测解码的技术,该技术已被用于提高其Gemini模型的性能,并将其能耗降低了约33倍。

总的来说,通过这些软硬件的协同优化,最终能帮助谷歌云客户将推理延迟降低高达 96%,吞吐量提高 40%,并将每个令牌的成本降低多达 30%。

除了这些芯片巨头,AI初创公司——Groq最近的融资也为推理芯片的热度再加一把燃料。Groq由前谷歌TPU工程师于2016年创立,专攻AI推理芯片。

2025年 9 月,Groq 宣布融资7.5 亿美元。这也是AI硬件领域最大的私人融资之一。自2024 年 8 月至 2025 年 9 月,Groq的估值已经从28亿美元跃升至 69 亿美元。而在2021 年,在老虎环球基金领投的一轮融资后,Groq 的估值略高于 10 亿美元。

此次融资由 Disruptive 领投,三星和思科也加入了这一轮融资。此外之前投资者D1 Capital、Altimeter 和其他之前支持过Groq 的公司也加入了进来。投资者的广泛性(从金融巨头到科技公司)凸显了人们对Groq的技术和市场方向的广泛信心。

Groq表示,新资金将用于加大芯片产量,计划到2025年第一季度部署超过108,000 个 LPU(14 纳米代),以满足需求。该公司还一直在投资人才,最近任命Stuart Pann(前英特尔员工)为首席运营官,甚至聘请Yann LeCun(Meta 的首席 AI 科学家)担任技术顾问。

除了风险投资,Groq的资金还因订单而增加。2025年 2 月,Groq从沙特阿拉伯获得了 15 亿美元的承诺,用于在沙特数据中心部署Groq的推理芯片;Groq 还成为贝尔加拿大 AI Fabric(一个横跨六个数据中心(计划容量为 500 兆瓦)的国家 AI 云网络)的独家推理提供商,Groq 芯片将于 2025 年为首批站点提供支持,贝尔选择Groq作为其主权人工智能基础设施的独家推理合作伙伴,理由是Groq比其他处理器“推理性能更快,而且成本低得多”。

Groq 的芯片被称为语言处理单元 (LPU),采用新颖的“张量流”架构。它们采用单个大核心,配备片上内存和确定性、软件调度的数据流,这与 GPU 的多核、基于缓存的设计不同。这使得延迟比领先的 GPU竞争对手低10倍,并且通过将数据保留在片上,内存带宽优势高达10 倍——非常适合实时AI推理。返回搜狐,查看更多